Как использовать ClipAI совместно с локальными ИИ (LLM)?

Практически всегда лучше всего использовать полностью бесплатные качественные ИИ (например, Google Gemini) в ClipAI. Для их использования вам не нужно выполнять действия, указанные в данной инструкции.

1. ПК с видеокартой не менее 8гб видеопамяти, либо устройство от Apple на m-процессоре (например, m1).

2. Наличие знаний опытного пользователя ПК.

В данной статье разберём, как подключить локальные ИИ к автоматическому написанию статей в ClipAI. Рассмотрим работу ClipAI с программой «LM Studio». При желании вы можете использовать практически любую другую программу: инструкции будут примерно одинаковы.

Настройка LM Studio

1. Скачайте LM Studio с официального сайта. Данная программа полностью бесплатна.

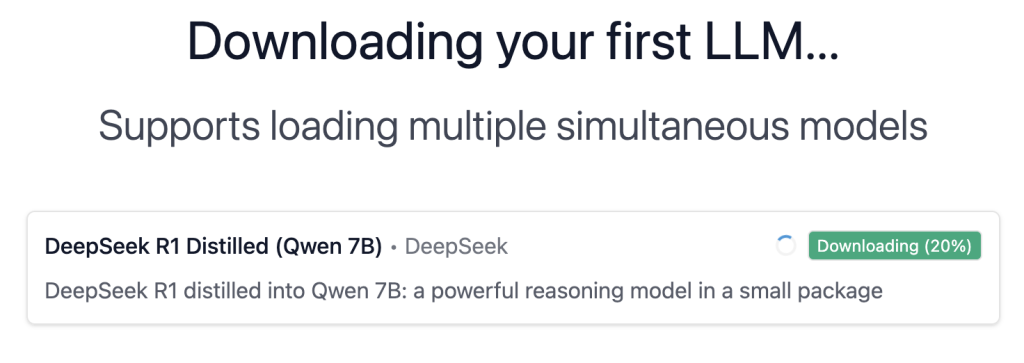

2. Пройдите установку и первый запуск LM Studio. В процессе первого запуска вам будет предложено скачать модель ИИ:

Скорее всего, вам будет предложена одна из самых простых моделей. Однако мы рекомендуем её скачать: будет проще сначала настроить работу, а затем изменять модель на необходимую.

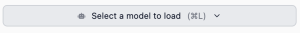

3. Выберите скачанную модель для использования, нажав сверху «Select a model to load», а затем выбрав необходимый ИИ:

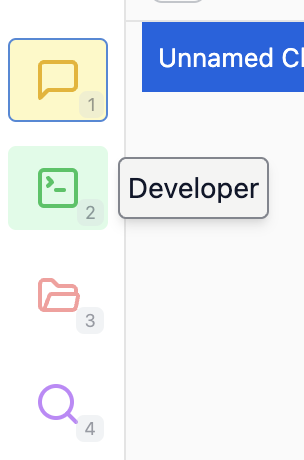

4. Слева окна LM Studio нажмите кнопку «Developer», а затем — «Start server»:

Настройка ClipAI

1. Зайдите в входные настройки ClipAI (правой кнопкой мыши на строку со скриптом -> «Настройки»). Затем перейдите в вкладку «Параметры».

2. Введите «Secret-ключ» — любой (например, «ClipAI»). Также выберите модель «GPT (своя модель)»:

3. Ниже, в разделе «ChatGPT», введите:

- «Своя модель» — название модели в LM Studio. Можно посмотреть либо вверху окна программы, либо в ответах чата с ИИ. Помните, в названии модели не должно быть пробелов. Например, в данном случае вам нужно ввести «deepseek-r1-distill-qwen-7b»:

- «Custom API Endpoint» — адрес, указанный на странице «Developer» -> «Reachable at» LM Studio, к которому нужно добавить «/v1/chat/completions». Скорее всего, на этой странице у вас будет указано «http://127.0.0.1:1234», а значит, в настройках ClipAI нужно указать «http://127.0.0.1:1234/v1/chat/completions»:

В итоге настройки в разделе «ChatGPT» программы ClipAI должны выглядеть примерно так:

Установка моделей ИИ в LM Studio

Чтобы скачать и установить модель ИИ, вам нужно лишь нажать кнопку «Discover» слева окна LM Studio:

После этого откроется окно поиска и установки различных нейронных сетей. Обычно, чем больше она «весит», и чем она новее, тем лучше качество статей. Но не забывайте, что размер нейронки не должен превышать объём вашего VRAM (память видеокарты), а в случае использования на компьютерах Mac на m-процессорах (например, macbook на m1) — вашей свободной RAM (оперативной памяти).

Не забудьте после установки новой ИИ изменить значение параметра «Своя модель» в вкладке «Параметры» входных настроек ClipAI!

Большинство ИИ оптимизировано для работы на английском языке. Мы рекомендуем использовать:

Для русскоязычных статей:

- YandexGPT (например, yandexgpt-5-lite) — хорошая нейронная сеть для коротких статей.

- Phi (например, phi-4) — подходит для многих языков, в т.ч. русского.

- Magnum (например, magnum-v4-12b) — довольно хорошо подходит для различных задач.

- Mistral (например, mistral-nemo-instruct) — очень хорошо пишет даже длинные статьи.

- Qwen (например, qwen2.5-7b-instruct-1m) — зачастую не может написать длинную статью, но неплохо пишет короткие, обычно не ошибаясь в HTML-разметке.

Для статей на китайском языке:

DeepSeek (например, deepseek-r1-distill-qwen-32b). Производит процесс «размышлений» перед написанием статьи, который хоть и не будет добавлен в итоговый текст, однако значительно влияет на повышение его качества. Пишет даже очень длинные статьи. Мы бы хотели добавить его в список рекомендованных для русского языка, однако данная ИИ часто встраивает китайские символы или англоязычные слова в текст.